|

Размер: 19120

Комментарий:

|

Размер: 21058

Комментарий:

|

| Удаления помечены так. | Добавления помечены так. |

| Строка 9: | Строка 9: |

| Других видимых различий в процедуре установки "Мастера" и ALTSP нет. Заметим, что пакетный состав дистрибутивов, естественно, различается. | Других видимых различий в процедуре установки "Мастера" и ALTSP нет. Заметим, что пакетный состав дистрибутивов, естественно, различается. Приглашение XDM на установленном "Линукс Терминале" выглядит так: |

| Строка 11: | Строка 11: |

| ''(Конец переведенной на данный момент части. Окончание работы над фрагментом --- сегодня утром.)'' -- DmitryChistikov <<DateTime(2008-07-14T01:07:18+0400)>> | {{attachment:../terminal_client_login.png}} |

| Строка 13: | Строка 13: |

| Запустим клиент. Что должен сделать системный администратор для настройки клиента? На всех машинах- терминалах должна быть настроена сетевая загрузка, причём, желательно, по умолчанию. Администратор также должен обеспечить, чтобы клиенты и сервер были в одной СПД. Сетевых загрузок бывает несколько видов, нам нужна та, которая называется PXE. По сути, это встроенный в сетевую карту достаточно полный большой клиент dhcp, bootp для получения IP-адреса и tftp для скачивания первичного загрузчика. |

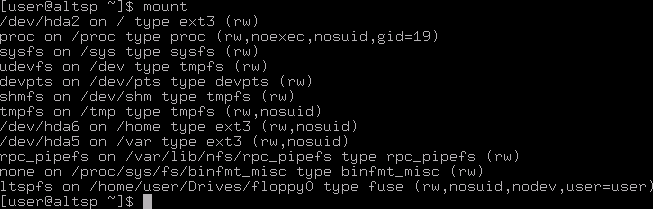

Организуем теперь запуск клиентских машин (машин-терминалов). В первую очередь необходимо убедиться, что клиенты и сервер находятся в общей СПД. Во вторую --- настроить на клиентах сетевую загрузку (желательно --- по умолчанию). Заметим, что способов загрузить машину по сети есть несколько. Нужный нам вариант называется PXE. Поддерживающие PXE сетевые карты могут получать настройки по DHCP (используется протокол BOOTP), а также использовать протокол TFTP для скачивания первичного загрузчика. Во время загрузки по сети экран клиентской машины может выглядеть, например, так: |

| Строка 19: | Строка 17: |

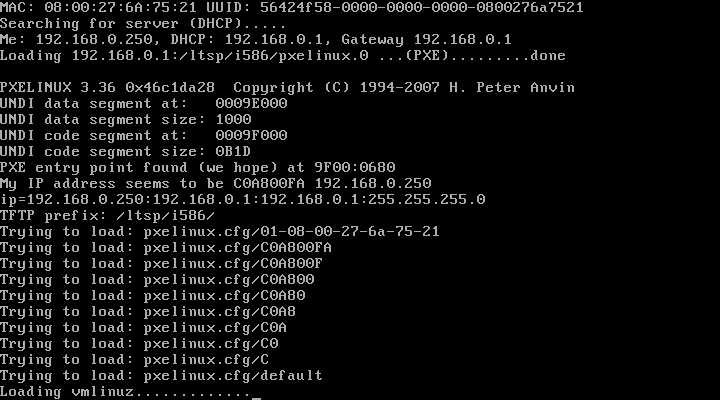

| Как видите подсказка у логина та же самая, но удалённый XDM знает, что к нему подключились не с локальной машины, поэтому в меню другой состав. | Если загрузка прошла успешно, то на экране клиентской машины мы увидим приглашение XDM, ничем с первого взгляда не отличающееся от приглашения XDM на сервере. Однако, как мы понимаем, появившееся приглашение обеспечивается работой программы xdm на сервере и программы X (X-сервера) на клиентской машине. Удаленный XDM знает о том, что к нему подключились по сети, и потому предложит другой состав меню. |

| Строка 21: | Строка 19: |

| {{attachment:../terminal_client_login.png}} {{attachment:../terminal_client_login_options.png}} |

Список меню на машине-сервере: |

| Строка 25: | Строка 22: |

| Список меню на машине-клиенте: {{attachment:../terminal_client_login_options.png}} |

|

| Строка 26: | Строка 25: |

| Какие проблемы связаны с такой организацией работы: *Проблема с разделением ресурсов- разделение на уровне пользователей. Если у вас в компьютерном зале 4 компьютера и один сервер то 4 пользователя работающие одновременно на одном сервере запускают соответственно 4 комплекта ПО. Если 24 компьютера и один сервер, то 24. Когда пользователи запускают n комплектов ПО, то они потребляют без малого n объемов оперативной памяти и едят без малого n промежутков процессорного времени и генерируют n потоков обмена данными с диском. |

Такая организация работы приводит нас к следующим проблемам: |

| Строка 29: | Строка 27: |

| Практика эксплуатирования терминальных классов показывает, что для того чтобы нормально работать пользователям (большой документ в OOffice и Firefox с несколькими вкладками) надо оперативной памяти примерно 256 мб под сервер плюс 8 клиентов по 256 мб(c KDE или аналогичной DE ) и еще 8 по 128 мб(например с xfce).Замеров загрузки CPU и обращений к диску не проводилось. Хотя опыт показывает что вместо одного диска лучше использовать RAID. Мораль --- если есть класс достаточно старых компьютеров и есть возможность купить современную нормальную машину, то это хорошее решение задачи. *проблема с доступом к ресурсам на уровне машин. |

* проблема разделения ресурсов; * проблема доступа к ресурсам. Рассмотрим их подробнее. === Проблема разделения ресурсов === Эта проблема касается разделения ресурсов между пользователями. Если в нашем компьютерном классе используются 4 клиентских и одна серверная машина, то 4 одновременно работающих на одном сервере пользователя запускают, соответственно, 4 комплекта программного обеспечения. Если сервер по-прежнему один, а клиентов 24, то комплектов запущенного ПО будет тоже 24. Когда пользователи запускают N комплектов ПО, то они потребляют без малого N объемов оперативной памяти, используют без малого N промежутков процессорного времени и генерируют N потоков обмена данными с дисковой подсистемой (по сравнению с одним комплектом ПО). Практика эксплуатирования терминальных классов показывает, что для нормальной работы пользователей (открыт большой документ в OpenOffice.org, запущен Mozilla Firefox с несколькими вкладками) необходимы следующие объемы оперативной памяти: примерно 256 MB для нужд сервера, по 256 MB для каждого из примерно 8 клиентов и по 128 MB для каждого из клиентов, начиная с девятого (если всего их больше восьми). Экономия при большом количестве клиентов может достигаться, к примеру, за счет эффективного использования механизма разделяемой памяти различными процессами. Заметим, что если использовать не KDE (или аналогичную по "тяжести" среду), а, скажем, XFCE, то на 8 клиентов может вполне хватить и 1 GB памяти. Замеров загрузки CPU и обращений к диску при исследованиях не проводилось. Опыт, тем не менее, говорит, что вместо одного диска разумно использовать RAID-массив. Так или иначе, если в наличии имеется целый класс достаточно старых компьютеров и есть возможность купить хорошую современную машину "под сервер", то исполь зование сетевой загрузки с "тонкими" клиентами является хорошим выбором. |

| Строка 68: | Строка 79: |

| }}} | }}} |

| Строка 94: | Строка 105: |

| || 25 || 1 || 1 || 1 || || 1 || ArtemSerebriyskiy, DmitryChistikov || || || | || 30 || 1 || 1 || 1 || || 1 || ArtemSerebriyskiy, DmitryChistikov || || || |

Терминальный сервер со стороны пользователя

Со временем, после появления версии 2.6 ядра Linux и виртуальной файловой системы sysfs, политика по оформлению и регистрации драйверов и аппаратного обеспечения компьютера изменилась и необходимость в сборке отдельного специфического ядра для терминальных клиентов отпала. LiveCD в ALT Linux, к примеру, изготавливается из самого обычного ядра с обычными модулями. Проект же LTSP, к сожалению, был сильно привязан к уже разработанной инфраструктуре и системе патчей, а потому непосредственная интеграция его в обычный дистрибутив не представлялась возможной. Сборка LTSP в рамках ALT Linux, к примеру, была большим bundle-файлом. Он выкладывался в определенное место, после чего целая коллекция скриптов настраивала нужные сервисы, --- только так это работало. Поэтому был создан ALTSP - ALT Linux Terminal Server Project. Его разработчики частично скопировали инфраструктуру LTSP, избежав при этом необходимости собирать специальное ядро. Результатом работы ALTSP стал специализированный дистрибутив, установка которого практически ничем не отличается от установки ALT Linux Мастер, за двумя исключениями:

- отсутствует раздел установщика "Разметка диска": дистрибутив требует для работы выделенный сервер, а потому на соответствующей стадии установки требуется лишь подтвердить передачу всего жесткого диска в распоряжение установщика;

дистрибутив требует наличия в компьютере двух сетевых карт, причем Интернет должен быть доступен через устройство eth0 (это в какой момент оно eth0? -- DmitryChistikov 2008-07-14 00:07:18), а локальная сеть (класс, машины в котором будут загружаться по сети) --- через eth1 (еще раз уточнить этот момент! -- DmitryChistikov 2008-07-14 00:07:18); устройство eth0 при этом должно получать IP-адрес статически (в случае DHCP создается специальная "обертка", позволяющая загрузиться со статическими настройками и затем перенастраивающаяся на DHCP), а IP-адрес для eth1 должен быть 192.168.0.1.

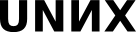

Других видимых различий в процедуре установки "Мастера" и ALTSP нет. Заметим, что пакетный состав дистрибутивов, естественно, различается. Приглашение XDM на установленном "Линукс Терминале" выглядит так:

Организуем теперь запуск клиентских машин (машин-терминалов). В первую очередь необходимо убедиться, что клиенты и сервер находятся в общей СПД. Во вторую --- настроить на клиентах сетевую загрузку (желательно --- по умолчанию). Заметим, что способов загрузить машину по сети есть несколько. Нужный нам вариант называется PXE. Поддерживающие PXE сетевые карты могут получать настройки по DHCP (используется протокол BOOTP), а также использовать протокол TFTP для скачивания первичного загрузчика. Во время загрузки по сети экран клиентской машины может выглядеть, например, так:

Если загрузка прошла успешно, то на экране клиентской машины мы увидим приглашение XDM, ничем с первого взгляда не отличающееся от приглашения XDM на сервере. Однако, как мы понимаем, появившееся приглашение обеспечивается работой программы xdm на сервере и программы X (X-сервера) на клиентской машине. Удаленный XDM знает о том, что к нему подключились по сети, и потому предложит другой состав меню.

Список меню на машине-сервере:

Список меню на машине-клиенте:

Такая организация работы приводит нас к следующим проблемам:

- проблема разделения ресурсов;

- проблема доступа к ресурсам.

Рассмотрим их подробнее.

Проблема разделения ресурсов

Эта проблема касается разделения ресурсов между пользователями. Если в нашем компьютерном классе используются 4 клиентских и одна серверная машина, то 4 одновременно работающих на одном сервере пользователя запускают, соответственно, 4 комплекта программного обеспечения. Если сервер по-прежнему один, а клиентов 24, то комплектов запущенного ПО будет тоже 24. Когда пользователи запускают N комплектов ПО, то они потребляют без малого N объемов оперативной памяти, используют без малого N промежутков процессорного времени и генерируют N потоков обмена данными с дисковой подсистемой (по сравнению с одним комплектом ПО).

Практика эксплуатирования терминальных классов показывает, что для нормальной работы пользователей (открыт большой документ в OpenOffice.org, запущен Mozilla Firefox с несколькими вкладками) необходимы следующие объемы оперативной памяти: примерно 256 MB для нужд сервера, по 256 MB для каждого из примерно 8 клиентов и по 128 MB для каждого из клиентов, начиная с девятого (если всего их больше восьми). Экономия при большом количестве клиентов может достигаться, к примеру, за счет эффективного использования механизма разделяемой памяти различными процессами. Заметим, что если использовать не KDE (или аналогичную по "тяжести" среду), а, скажем, XFCE, то на 8 клиентов может вполне хватить и 1 GB памяти.

Замеров загрузки CPU и обращений к диску при исследованиях не проводилось. Опыт, тем не менее, говорит, что вместо одного диска разумно использовать RAID-массив. Так или иначе, если в наличии имеется целый класс достаточно старых компьютеров и есть возможность купить хорошую современную машину "под сервер", то исполь зование сетевой загрузки с "тонкими" клиентами является хорошим выбором.

- Мы решили ровно одну проблему --- мы разделили запуск задач и ввод/вывод, но ввод\вывод исключительно связанный с графической подсистемой X11. Все что связанно с X11 отлично разделяется на клиенте и сервере - задача запускается на машине-сервере, а ввод\вывод X11 - на рабочей станции. Но таким образом не решаются следующие проблемы:

- если например программа звук играет, то играть она будет на машине-сервере.

- Однако гораздо интереснее момент, когда пользователь поработал, достал из кармана флешку и вставил её в ... рабочую станцию. Между тем все файлы с которыми он работал, все что он видит на экране работает на сервере. А ввод\вывод на флешку надо осуществлять на клиенте.

- первое --- по окончании работы все пользователи выстраиваются в очередь к администратору с флешками. Это решение на самом деле вполне реально если у вас учебный класс.

Для решения этой проблемы в терминале проделана дополнительная работа.

$ mount /dev/hda2 on / type ext3 (rw) proc on /proc type proc (rw,noexec,nosuid,gid=19) sysfs on /sys type sysfs (rw) udevfs on /dev type tmpfs (rw) devpts on /dev/pts type devpts (rw) shmfs on /dev/shm type tmpfs (rw) tmpfs on /dev/tmp type tmpfs (rw,nosuid) /dev/hda6 on /home type ext3 (rw,nosuid) none on /proc/sys/fs/binfmt_misc type binfmt_misc (rw) ltspfs on /home/user/Drives/floppy0/ type fuse (rw,nosuid,nodev,user=user)

Если посмотреть на mount, обратите внимание на последнюю строчку. Это некое волшебное действие, которое производится на сервере, чтобы возвратить имеющееся устройство обратно на клиент. То есть у пользователя будет в домашнем каталоге подкаталог Drives, а в нем соответствующий подкаталог floppy0, который будет соответствовать дискетке подключенной к терминальному клиенту.

- На скриншоте /*виден этот файл под названием floppy и*/ видна иконка на панели под названием "отмонтированная дискета". Идея состоит в следующем: устройство, подключённое к локальной машине, то есть к рабочей станции, неким образом (с помощью fuse) прокидивается на сервер. Собственно именно этому соответствует эта строка. Тем самым, когда вы запускаете на сервере программу, которая обращается сюда, в результате она заходит на рабочую станцию к соответствующему каталогу. Аналогично с CD/DVD-приводами. Для нелюбознательного пользователя это выглядит как работа с обычной машиной. Хитрость в том, что всё работает на сервере, а диск доступен на сервере именно путём обратного проброса. Посмотрим ещё раз mount.

$ mount /dev/hda2 on / type ext3 (rw) proc on /proc type proc (rw,noexec,nosuid,gid=19) sysfs on /sys type sysfs (rw) udevfs on /dev type tmpfs (rw) devpts on /dev/pts type devpts (rw) shmfs on /dev/shm type tmpfs (rw) tmpfs on /dev/tmp type tmpfs (rw,nosuid) /dev/hda6 on /home type ext3 (rw,nosuid) none on /proc/sys/fs/binfmt_misc type binfmt_misc (rw) ltspfs on /home/user/Drives/floppy0/ type fuse (rw,nosuid,nodev,user=user) ltspfs on /home/user/Drives/atacd-hdc/ type fuse (rw,nosuid,nodev,user=user) /dev/hdc on /media/cdrom type iso9660 (rw,noexec,nosuid,nodev,utf8,user=user)

То же самое творится со звуком. Но со звуком есть одна неприятная особенность, которая состоит в следующем: из-за того, что работа со звуковой подсистемой в разных видах Unix-систем устроена немного по разному, далеко не все программы в действительности легко работают с таким пробросом звука на клиент. Для решения используется ESD и PulseAudio. Проброс звука делается следующим образом: для тех программ, которые умеют в качестве выходного устройства использовать не конкретные устройства (/dev/dsp), а предоставляют возможность выбора, для них используется самый простой из всех возможных способов. На клиентской машине запускается ESD(Enlightened Sound Daemon) --- программа, которая по специальному протоколы принимает подключения по сети( эти подключения связаны с проигрыванием звука) и проигрывает звук. На сервере устанавливается переменная окружения ESPEAKER, которая указывает, тем программам которые умеют работать с ESD что звук надо выводить не на текущую машину, а подключаться по указанному адресу. Все программы, которые скомпилированы с libesd, работают таким образом. Для тех машин, которые не умеют это делать, но умеют работать с pulseaudio, запускается ещё и pulseaudio-сервер,который делает ровно тоже самое. Все программы, которые работают с alsa с помощью специального плагина для alsa и pulseaudio тоже в итоге работают сетевым образом. Лишь те программы которые по старинке пишут сразу в /dev/dsp работают с /dev/dsp и поэтому звук прокинут быть не может. Поэтому множество запущенных таких программ создают страшную какофонию. Лечится это очень простым способом --- нужно убить звуковую карту на сервере (открутить её, поставить в черный список её модуль), - в общем сделать так чтобы /dev/dsp отсутствовал.

Речь о терминальном классе идёт в двух случаях:

- Первый случай --- эксплуатация старого железа.

- Второй случай --- если ваш рабочий процесс не страдает от использования терминальных клиентов, то тогда в итоге администрированию подлежит одна машина, а не все в классе. При этом экономится много времени. Переустановка ПО при этом как-бы делается сама- что вы на сервере поставили, то сразу на всех клиентах появилось.

Недостатки терминального класса:

- Современные X Window System не работают например на s3 trio64.

- Еще один значимый недостаток терминального сервера --- один пользователь не может одновременно работать на двух терминальных клиентах.Т.е. при работе через тонкий терминальный клиент каждый сеанс работы(пользователь сидящий за терминальным клиентом) должен использовать использовать отличную от других учетную запись. С другой стороны, на сегодняшний день только "Линукс терминал" обеспечивает концепцию терминального класса и мобильного рабочего места. Реализуется это тем, что у каждого пользователя есть личные персональные записи, хранящиеся на сервере, которые он эксплуатирует и использовать чужие ему не позволяется. Это делается централизованно и абсолютно прозрачно с помощью Альтератора, который заводит пользователей на сервере(потому что больше нигде заводить их не надо).

Сведения о ресурсах

Готовность (%) |

Продолжительность (ак. ч.) |

Подготовка (календ. ч.) |

Полный текст (раб. д.) |

Предварительные знания |

Level |

Maintainer |

Start date |

End date |

30 |

1 |

1 |

1 |

|

1 |

|

|